Artificial Intelligence Act (AIA): Unterschied zwischen den Versionen

Walter (Diskussion | Beiträge) →Differenzierung: GPAI-Modelle ohne/mit systemischem Risiko (Art 51-52 AI Act): Kapitel Sicherheit des GPAI CoP |

|||

| Zeile 316: | Zeile 316: | ||

===== "Eigenständige" Hochrisiko-KI-Systeme (stand-alone high-risk AI systems) (Art 6 Abs 2 AI Act) ===== | ===== "Eigenständige" Hochrisiko-KI-Systeme (stand-alone high-risk AI systems) (Art 6 Abs 2 AI Act) ===== | ||

Die zweite Variante von "eigenständigen" Hochrisiko-KI-Systemen wird durch Art 6 Abs 2 AI Act definiert, der dabei auf Anhang III verwiest. Dieser enthält acht Bereiche, untergliedert in konkretere Anwendungsfelder, die ebenfalls als hochriskant gelten: bspw biometrische Identifizierung, kritische Infrastrukturen, grundlegende öffentliche und private Dienste/Leistungen, Strafverfolgung, Migration, Asyl und Grenzkontrolle, Justiz und demokratische Prozesse | Die zweite Variante von "eigenständigen" Hochrisiko-KI-Systemen wird durch Art 6 Abs 2 AI Act definiert, der dabei auf Anhang III verwiest. Dieser enthält acht Bereiche, untergliedert in konkretere Anwendungsfelder, die ebenfalls als hochriskant gelten: bspw biometrische Identifizierung, kritische Infrastrukturen, grundlegende öffentliche und private Dienste/Leistungen, Strafverfolgung, Migration, Asyl und Grenzkontrolle, Justiz und demokratische Prozesse. | ||

Diese Liste kann dabei mittels delegierter Rechtsakte der Kommission geändert werten (Art 7 AI Act). | Diese Liste kann dabei mittels delegierter Rechtsakte der Kommission geändert werten (Art 7 AI Act). | ||

Version vom 1. Dezember 2025, 09:36 Uhr

Verordnung (EU) 2024/1689 | |

|---|---|

| Titel: | Verordnung (EU) 2024/1689 des Europäischen Parlaments und des Rates vom 13. Juni 2024 zur Festlegung harmonisierter Vorschriften für künstliche Intelligenz und zur Änderung der Verordnungen (EG) Nr. 300/2008, (EU) Nr. 167/2013, (EU) Nr. 168/2013, (EU) 2018/858, (EU) 2018/1139 und (EU) 2019/2144 sowie der Richtlinien 2014/90/EU, (EU) 2016/797 und (EU) 2020/1828 |

| Kurztitel: | Verordnung über Künstliche Intelligenz |

| Bezeichnung: (nicht amtlich) |

AI Act (AIA)/KI-VO |

| Geltungsbereich: | EWR |

| Rechtsmaterie: | Binnenmarkt, Künstliche Intelligenz |

| Grundlage: | AEUV, insbesondere Art. 114 |

| Anzuwenden ab: | 2. Februar 2025 (schrittweise) |

| Fundstelle: | ABl L 2024/1689, 1 |

| Volltext | Konsolidierte Fassung (nicht amtlich) Grundfassung |

| Regelung ist in Kraft getreten und anwendbar. | |

| Hinweis zur geltenden Fassung von Rechtsakten der Europäischen Union | |

Kurzübersicht

| Ziele | Anwendungsbereich | Inhalt | Synergien | Konsequenzen |

|---|---|---|---|---|

| Förderung von Innnovation und Vertrauen | Anbieter (häufig Entwickler) bei in Verkehr bringen/in Betrieb nehmen von KI-Systemen | risikobasierter Ansatz | direkte Verknüpfung mit der RL über außervertragliche

Haftung (AILD, von der Kommission zurückgezogen) |

Geldbußen von bis zu 35 000 000 Euro/7% des gesamten weltweiten Jahresumsatzes (Verstoß gegen verbotene Praktiken) |

| Wahrung der Grundrechte und Sicherheit von EU-Bürger*innen | GPAI-Modelle (general purpose AI) | Verbote von besonders riskanten Praktiken (zB social scoring, manipulative Systeme) | einige Querbezüge zur DSGVO (zB Verarbeitung zur Vermeidung von Verzerrungen, Art 10), regulatory sandboxes | Geldbußen von bis zu 15 000 000 Euro/3 % des gesamten weltweiten Jahresumsatzes (zB Anbieter- und Betreiberpflichten, Verstöße gegen Pflichten von Anbietern von GPAI-Modellen) |

| Förderung des Binnenmarktes | Ausnahmen: militärische Zwecke; Systeme unter open-source-Lizenz (eingeschränkt); reine Forschungszwecke

Inkrafttreten am 1. August 2024; Geltung ab 2. August 2026; einige Aspekte (verbotene Systeme) gelten seit 2. Februar 2025 |

strenge Regulierung von Hochrisiko-

KI-Systemen (zB Risikomanagement, Datenqualität, Dokumentation, Transparenz, menschliche Aufsicht) |

Integrierung/Kombination von Anforderungen stellenweise möglich (zB Riskomanagementsysteme) | Geldbußen von bis zu 7 500 000 Euro/1% des gesamten weltweiten Jahresumsatzes (Bereitstellung von falschen, unvollständigen oder irreführenden Informationen) |

| Gewährleistung von Transparenz und Verantwortlichkeit | Pflichten für Betreiber (professionelle Nutzer*innen) und Anbieter | Transparenzpflichten für gewisse KI-Systeme (zB Chatbots, Deepfakes) | Informationspflichten nach der DSGVO | Geldbußen von bis zu 15 000 000 Euro/3% des gesamten weltweiten Jahresumsatzes |

Einführung

Der AI Act ist die erste EU-weite, sektorübergreifende Regulierung von Künstlicher Intelligenz (KI) und folgt dabei primär einem produktsicherheitsrechtlichem Ansatz, dessen vorrangiges Regulierungsziel die Sicherheit von KI-Systemen und Modellen ist. Damit ist er Teil des sog "New Legislative Framework" (NLF), einem unionsrechtlichen Maßnahmenpaket zur Produktregulierung, das auf die Verbesserung der Marktüberwachung abzielt und sich durch einheitliche Kernelemente auszeichnet (zB Konformitätsbewertungsverfahren, Selbstregulierung, Standards und einheitliche Anforderungen). Im Rahmen des Gesetzgebungsprozesses wurde der Rechtsakt - insbesondere auf Bestreben des Europäischen Parlaments - um menschenrechtliche Aspekte und Betroffenenrechte erweitert, weshalb der AI Act mittlerweile deutlich über reines Produktsicherheitsrecht hinausgeht.

Der AI Act verfolgt dabei kontrastierende Ziele: So soll das Funktionieren des Binnenmarktes durch einen einheitlichen Rechtsrahmen verbessert, menschenzentrierte und vertrauenswürdige KI gefördert und gleichzeitig ein hohes Schutzniveau in Bezug auf Gesundheit, Sicherheit und der Grundrechte sichergestellt, der Schutz vor schädlichen Auswirkungen von KI-Systemen gewährleistet und gleichzeitig die Innovation unterstützt werden (ErwGr 1 AI Act).

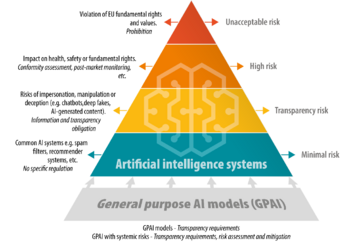

Kernstück des AI Act ist ein risikobasierter Ansatz, der KI-Systeme nach dem mit ihnen verbundenen Risiko in vier Klassen einteilt und KI-Systeme mit inakzeptablem Risiko verbietet, Hochrisiko-KI-Systeme stark reguliert, für gewisse Systeme lediglich Transparenzpflichten vorsieht und Systeme mit minimalem Risiko unberührt lässt.

Durch die Prominenz von ChatGPT wurden spät im Gesetzgebungsprozess auch noch spezielle Bestimmungen in Bezug auf sog general purpose AI (GPAI) Modelle bzw KI-Modelle mit allgemeinem Verwendungszweck eingefügt.[1]

Anwendungsbereich

Sachlicher Anwendungsbereich

KI-Systeme

Zentraler Anknüpfungspunkt für die Anwendbarkeit des AI Act ist dabei das Vorliegen eines "KI-Systems".[2] Dabei handelt es sich um "ein maschinengestütztes System, das für einen in unterschiedlichem Grade autonomen Betrieb ausgelegt ist und das nach seiner Betriebsaufnahme anpassungsfähig sein kann und das aus den erhaltenen Eingaben für explizite oder implizite Ziele ableitet, wie Ausgaben wie etwa Vorhersagen, Inhalte, Empfehlungen oder Entscheidungen erstellt werden, die physische oder virtuelle Umgebungen beeinflussen können."[3]

Das wichtigsten Abgrenzungsmerkmal der breit gehaltenen Definition ist die Fähigkeit, abzuleiten. Diese Fähigkeit kann sich auf den Prozess der Erzeugung von Ausgaben sowie auf die Fähigkeit, Modelle oder Algorithmen oder beides aus Eingaben oder Daten abzuleiten, beziehen. Der Begriff umfasst damit sowohl Machine-Learning- als auch (ältere) logik- und wissensgestützte Ansätze.

Hingegen soll sich nach ErwGr 12 der Begriff "KI-System" "nicht auf Systeme beziehen, die auf ausschließlich von natürlichen Personen definierten Regeln für das automatische Ausführen von Operationen beruhen [...]", womit auf eine Abgrenzung von KI von herkömmlichen Softwarelösungen und Programmierungsansätzen abgezielt wird.

Zusammenfassend möchte der EU-Gesetzgeber mit dieser Definition einerseits Rechtssicherheit schaffen, allerdings immer noch Raum für technologischen Fortschritt lassen, um den Anwendungsbereich des AI Act nicht von Vornherein vor potenziellen künftigen technologischen Entwicklungen zu verschließen. Dennoch wurde die Definition als zu vage und unbestimmt empfunden. So wurden diverse Unklarheiten bemängelt, zB ob hybride (neurosymbolische) Systeme unter den Begriff fallen.[4] Um den Begriff des KI-Systems also zu konkretisieren und Unsicherheiten zu beseitigen, sollte die Kommission gemäß Art 96 Abs 1 lit f AI Act Leitlinien vorlegen, und damit eine einheitliche Anwendung des Regelwerks fördern sowie Rechtsicherheit gewährleisten.[5] Die entsprechenden (unverbindlichen) Leitlinien der Kommission wurden am 6. Februar 2025 veröffentlicht und stellen bspw klar, welche Systeme nicht in den Anwendungsbereich fallen (zB etablierte lineare Modelle, einfache Datenverarbeitungssysteme, auf klassische Heuristik gestützte Systeme, einfache Vorhersagesysteme etc.).[6] Eine Positiv-Liste, welche Systeme jedenfalls unter den KI-Begriff fallen, enthalten die Leitlinien allerdings nicht. Sie orientieren sich vielmehr an den 7 Kernelementen der KI-Definition gemäß Art 3 Z 1 AI Act. Es wird überdies betont, dass nicht alle Elemente kontinuierlich in den beiden Hauptphasen des Lebenszyklus von KI ("building phase" / "pre-deployment" oder "use phase" / "post-deployment") vorhanden sein müssen und, dass sich die Leitlinien kontinuierlich weiterentwickeln sollen.

Folgende Konkretisierungen der KI-Definition und Beispiele sind den Leitlinien zu entnehmen:

| Elemente der KI-Definition | Erläuterungen in den Leitlinien der EU-Kommission | Beispiele |

|---|---|---|

| Maschinengestütztes System | KI benötigt Hardware- und Softwarekomponenten | zB eine Hardwareinfrastruktur wie processing units, Speicher, Input/Output-Schnittstellen und Software (Code, Programme etc.) |

| autonomer Betrieb (in unterschiedlichem Grade) | Erfordert einen gewissen Grad an Unabhängigkeit von menschlichem Eingreifen, wobei Systeme, die vollständig manuelle menschliche Interaktion erfordern, nicht darunter fallen. | Umfasst sind Systeme, die zwar einen manuellen Input erfordern, aber von selbst einen Output generieren (zB Chatbots) |

| Anpassungsfähigkeit nach Betriebsaufnahme (optional) | Selbstlernfähigkeiten (nicht zwingend erforderlich); darunter versteht man, ob sich das Verhalten des Systems während seiner Verwendung anpassen oder verändern kann (zB automatisches Lernen, wie Muster oder Beziehungen zwischen Daten erkannt werden können). | |

| Ableitungsfähigkeit | Inferenz, Schlüsseleigenschaft; dient der Abgrenzung von KI-Systemen von einfacheren herkömmlichen Softwaresystemen und Programmierungsansätzen. Nicht umfasst sind hingegen Systeme, die nur von Menschen programmierten Regeln folgen und automatisiert Operationen ausführen. Die Ableitungsfähigkeit bedeutet daher die Erlernung allgemeiner Konzepte statt fester, vorprogrammierter Regeln. | Bsp: maschinelles Lernen, logik- und wissensgestützte Systeme (Schlussfolgerungen mittels Deduktion oder Induktion) |

| Ableitung aus Eingaben für implizite oder explizite Ziele | Ableitungen müssen nach entweder:

|

|

| Erzeugung von Ausgaben | Ausgabe-Arten umfassen unter anderem

|

zB die generierten Inhalte von Chatbots, Produktvorschläge, Echtzeit-Vorhersagen, Auswahlentscheidungen |

| Beeinflussung physischer oder virtueller Umgebungen | Frage, ob das System einen aktiven Einfluss auf die Umgebungen hat, in denen es eingesetzt wird, sei es auf materielle physische Objekte oder auf digitale Räume | zB Roboterarm, Software-Ökosysteme, Datenströme |

GPAI-Modelle/Modelle mit allgemeinem Verwendungszweck

General Purpose AI-Modelle (auf Deutsch "Modelle mit allgemeinem Verwendungszweck"[7]) zeichnen sich durch ihre erhebliche allgemeine Verwendbarkeit und der Fähigkeit aus, ein breites Spektrum unterschiedlicher Aufgaben kompetent zu erfüllen. Der Begriff "Modell" darf dabei, da Modelle gesondert reguliert werden, nicht mit dem Begriff eines KI-Systems verwechselt werden. Denn damit "KI-Modelle zu KI-Systemen werden, ist die Hinzufügung weiterer Komponenten, zum Beispiel einer Nutzerschnittstelle, erforderlich" (ErwGr 97 AI Act). Man kann hier den Vergleich zu einem KFZ ziehen, wobei das KI-Modell den Motor darstellt, der die eigentliche "Arbeit" leistet. Um jedoch fahrtüchtig zu sein, bedarf es nicht nur eines Motors, sondern das Fahrzeug benötigt darüber hinaus eine Karosserie, Räder, ein Lenkrad etc. Das wiederum bezeichnet das KI-System, welches das Modell erst durch seine Schnittstellen, seine Benutzeroberfläche etc. "fahrtüchtig" und damit nutzbar macht. Ein KI-System bzw GPAI-System,[8] das auf einem GPAI-Modell beruht, muss dabei wiederum nach dem risikobasierten Ansatz des AI Act eingestuft werden.

Personeller Anwendungsbereich

In Bezug auf die Akteure ist primär zwischen Anbietern und Betreibern zu unterscheiden.

Anbieter ist eine Person, Behörde, Einrichtung oder sonstige Stelle, die ein KI-System oder ein KI-Modell mit allgemeinem Verwendungszweck entwickelt oder entwickeln lässt (Art 3 Z 3 AI Act).

Betreiber (in früheren Fassungen "Nutzer") ist eine Person, Behörde, Einrichtung oder sonstige Stelle, die ein KI-System in eigener Verantwortung verwendet (Art 3 Z 4 AI Act).

Daneben existieren auch weniger relevante Akteure wie Einführer, Händler und Bevollmächtigte.

(Geographischer) Anwendungsbereich (Art 2 AI Act)

Der (geographische) Anwendungsbereich des AI Act (Art 2) umfasst dabei primär:[9]

- Anbieter, die in der Union KI-Systeme in Verkehr bringen[10] oder in Betrieb nehmen[11] oder KI-Modelle mit allgemeinem Verwendungszweck in Verkehr bringen, unabhängig davon, ob diese Anbieter in der Union oder in einem Drittland niedergelassen sind

- Betreiber von KI-Systemen, die ihren Sitz in der Union haben oder sich in der Union befinden

- Anbieter und Betreiber von KI-Systemen, die ihren Sitz in einem Drittland haben oder sich in einem Drittland befinden, wenn die vom KI-System hervorgebrachte Ausgabe in der Union verwendet wird

Ausnahmen (Art 2 Abs 2 ff AI Act)

Art 2 Abs 2 ff AI Act enthält eine Reihe von Ausnahmen vom Anwendungsbereich, wobei hier die wichtigsten vorgestellt werden sollen:

- Bereiche, die nicht unter das Unionsrecht fallen (zB nationale Sicherheit): KI-Systeme (ausschließlich) für militärische Zwecke, Verteidigungszwecke oder Zwecke der nationalen Sicherheit

- KI-Systeme/KI-Modelle, die eigens für den alleinigen Zweck der wissenschaftlichen Forschung und Entwicklung entwickelt und in Betrieb genommen werden.

- Forschungs-, Test- und Entwicklungstätigkeiten zu KI-Systemen/KI-Modellen, bevor diese in Verkehr gebracht oder in Betrieb genommen werden.[12]

- Der AI Act gilt für Betreiber, die natürliche Personen sind und KI-Systeme im Rahmen einer ausschließlich persönlichen und nicht beruflichen Tätigkeit verwenden ("Haushaltsausnahme")

| Hinweis zur Sonderregelung von älterem Produktsicherheitsrecht (zB Mobilität) |

|---|

| Produkte, die unter Produktsicherheitsvorschriften mit dem älteren Ansatz (old approach) fallen und in Anhang I Abschnitt B gelistet werden (zB Luftfahrt und Mobilität), unterliegen nur eingeschränkt dem AI Act (Art 2 Abs 2 AI Act). Sie sind zwar nicht vollständig vom Anwendungsbereich ausgenommen, für sie gelten jedoch nur wenige Bestimmungen (Art 6 Abs 1, Art 102-109, Art 112 und Art 57 AI Act zu Reallaboren).

In der Praxis werden die Anforderungen des AI Act dabei "indirekt" im Wege der delegierten Gesetzgebung/von Durchführungsrechtsakten dieser Produktsicherheitsrechtsakte zur Anwendung kommen. Die Trennung von Anhang I in Abschnitt A, der direkt dem AI Act unterfällt, und Abschnitt B, für den diese Wirkung indirekt erzielt wird, sollte somit in der Praxis beachtet werden. |

Zeitlicher Anwendungsbereich (Art 113 AI Act)

Der AI Act trat am 1. August 2024 in Kraft und wird generell am 2. August 2026 anwendbar (Art 113 AI Act). Gestaffelt erlangen einige Bestimmungen jedoch bereits vorab oder danach Geltung:[13]

- allgemeine Bestimmungen (inklusive KI-Kompetenz) und verbotene Praktiken ab 2. Februar 2025

- Bestimmungen über Notifizierende Behörden und notifizierte Stellen; GPAI-Modelle, Governance, Sanktionen, Vertraulichkeit ab 2. August 2025

- Artikel 6 Absatz 1 (eingebettete Hochrisiko-KI-Systeme) und die entsprechenden Pflichten ab dem 2. August 2027

Art 111 Abs 2 AI Act enthält dabei jedoch eine sog „grandfathering“-Klausel, nach welcher der AI Act für Betreiber von Hochrisiko-KI-Systemen, die vor dem 2. August 2026 in Verkehr gebracht oder in Betrieb genommen wurden, nur dann gilt, wenn diese Systeme danach in ihrer Konzeption erheblich verändert wurden.[14]

Zentrale Inhalte

KI-Kompetenz/AI literacy (Art 4 AI Act)

Als allgemeine Bestimmung für alle KI-Systeme fordert Art 4 AI Act, dass die Anbieter und Betreiber von KI-Systemen Maßnahmen ergreifen, um nach besten Kräften sicherzustellen, dass ihr Personal und andere Personen, die in ihrem Auftrag mit dem Betrieb und der Nutzung von KI-Systemen befasst sind, über ein ausreichendes Maß an "KI-Kompetenz" verfügen. Dabei sind ihre technischen Kenntnisse, ihre Erfahrung, ihre Ausbildung und Schulung und der Kontext, in dem die KI-Systeme eingesetzt werden sollen, sowie die Personen oder Personengruppen, bei denen die KI-Systeme eingesetzt werden sollen, zu berücksichtigen.

Die Verpflichtung zur Maßnahmenergreifung gilt für Betreiber und Anbieter gleichermaßen und ist ferner unabhängig von der Risikoklasse der infragestehenden KI-Anwendung.

Unter KI-Kompetenz versteht man grundsätzlich "die Fähigkeiten, die Kenntnisse und das Verständnis, die es Anbietern, Betreibern und Betroffenen unter Berücksichtigung ihrer jeweiligen Rechte und Pflichten im Rahmen dieser Verordnung ermöglichen, KI-Systeme sachkundig einzusetzen sowie sich der Chancen und Risiken von KI und möglicher Schäden, die sie verursachen kann, bewusst zu werden."[15] Dies umfasst die notwendigen Kompetenzen, um fundierte Entscheidungen über KI-Systeme zu treffen, technische Elemente zu verstehen sowie korrekt anzuwenden, die Auswirkungen von KI-basierten Entscheidungen auf Betroffene zu verstehen und KI-generierte Ausgaben angemessen zu interpretieren.[16] Dazu gehört auch, den einschlägigen Akteuren der KI-Wertschöpfungskette jene erforderlichen Kenntnisse zu vermitteln, um die Einhaltung und Durchsetzung der Vorschriften des AI Act zu gewährleisten.

Weitere Konkretisierungen oder zwingende Mindestvorgaben für die Sicherstellung der KI-Kompetenz enthält der AI Act allerdings nicht und betont sogar, dass die Konzepte der KI-Kompetenz in Bezug auf den jeweiligen Kontext unterschiedlich sein können.[16] Die EU-Kommission hat daher ein "Living Repository" angelegt, in dem Unternehmen ihre Praktiken in Bezug auf KI-Kompetenz eingetragen haben. Das Repository wird laufend ergänzt, ist jedoch nicht rechtsverbindlich. Weiters bilden die darin enthaltenen Praktiken keine Garantie zur Compliance mit Art 4 AI Act, allerdings stellen sie eine gute Orientierung dar, welche Maßnahmen zur Sicherstellung von KI-Kompetenz in unterschiedlichen Branchen bereits ergriffen werden. Häufig genannte Praktiken umfassen:

- interne eLearning-Plattformen,

- interne Weiterbildungen und Trainingsprogramme,

- Kenntnis-basierte Schulungen,

- Video-/Podcast-Reihen,

- spielebasierte Trainings,

- Erstellung von KI-Verhaltenskodizes und Risikobewertungssystemen,

- eigene Chatbots zum Training im Umgang mit Sprachmodellen.

Denkbar ist überdies die Teilnahme an externen Fortbildungen und Schulungen, die Entwicklung von internen Richtlinien ("KI-Guidelines") oder die Schaffung von sog "KI-Beauftragten" in der Organisation. Ob die Schulungsmaßnahmen fortlaufend zu erfolgen haben, ist rechtlich nicht vorgeschrieben, wird allerdings anzunehmen sein.[17] Ebensowenig sind die genauen Inhalte der Kompetenzvermittlungsmaßnahmen definiert. Es kann jedenfalls davon ausgegangen werden, dass diese zielgruppengerecht und zugeschnitten auf unterschiedliche Bedürfnisse erfolgen sollten. Weiters werden sie sich bei manchen Branchen, KI-Einsatzgebieten oder Personengruppen nicht lediglich auf rechtliche oder technische Anforderungen beschränken, sondern ebenso soziale und ethische Komponenten umfassen. Bei der Entwicklung und Nutzung von GPAI-Modellen wird beispielsweise die Vermittlung von Kenntnissen im Zusammenhang mit Urheberrecht, Datenschutz, "Bias" (Verzerrungen) oder "Halluzinationen" (erfundene falsche Ausgaben) sinnvoll sein.[18]

Die EU-Kommission hat darüber hinaus eine "FAQ-Seite" mit Fragen und Antworten zur KI-Kompetenz angelegt, um einen besseren Überblick über die Anforderungen zu geben.

KI-Systeme mit inakzeptablem Risiko/verbotene Praktiken (Art 5 AI Act)

Nach Art 5 AI Act sind gewisse Praktiken im KI-Bereich verboten, da sie besonders schädlich sind, enormes Missbrauchspotenzial aufweisen und im Widerspruch zu europäischen Grundrechten und Grundfreiheiten stehen.[19] (Unverbindliche) Leitlinien der Kommission zu den verbotenen Praktiken konkretisieren die verbotenen Praktiken insbesondere durch zahlreiche Beispiele.[20] Folgende Praktiken sind davon umfasst:

| Praktik | Beispiele | Nicht erfasste Praktiken | Rechtsgrundlage |

|---|---|---|---|

| Unterschwellige Beeinflussung außerhalb des Bewusstseins oder manipulative/täuschende Techniken, wodurch die freie Entscheidungsfähigkeit von Personen beeinträchtigt wird und ein Schaden mit hinreichender Wahrscheinlichkeit eintritt | Erlaubt ist hingegen der Einsatz eines KI-Systems, das personalisierte Empfehlungen auf der Grundlage transparenter Algorithmen und Nutzerpräferenzen verwendet, und sich nicht absichtlich manipulativer Techniken bedient.[24] | Art 5 Abs 1 lit a | |

| Ausnutzen der Vulnerabilität/Schutzbedürftigkeit aufgrund des Alters, einer Behinderung oder einer bestimmten sozialen oder wirtschaftlichen Situation |

|

|

Art 5 Abs 1 lit b |

| Social scoring (Bewertung/Einstufung von Personen/Gruppen von Personen auf der Grundlage ihres sozialen Verhaltens/Eigenschaften/Persönlichkeitsmerkmale) |

|

|

Art 5 Abs 1 lit c |

| Bewertung des Risikos, dass eine Person eine Straftat begeht (ausschließlich aufgrund von Profiling) | Eine Polizeidienststelle verwendet KI-gestützte Risikobewertungsinstrumente, um das Risiko zu bewerten, dass kleine Kinder und Jugendliche an „künftigen Gewalttaten und Eigentumsdelikten“ beteiligt sein werden. Das System bewertet Kinder auf der Grundlage ihrer Beziehungen zu anderen Menschen und deren vermeintlichen Risikoniveaus, dh es wird eventuell davon ausgegangen, dass bei Kindern ein höheres Risiko für die Begehung von Straftaten besteht, einfach weil sie mit einer anderen Person wie einem Geschwisterkind oder einem Freund verbunden sind, bei der eine hohe Risikobewertung vorliegt. Das Risikoniveau der Eltern kann sich ebenfalls auf das Risikoniveau eines Kindes auswirken.[29] |

|

Art 5 Abs 1 lit d |

| Erstellung/Erweiterung von Datenbanken zur Gesichtserkennung durch ungezieltes Auslesen von Gesichtsbildern | Ein Unternehmen für Gesichtserkennungssoftware sammelt Bilder von Gesichtern, die mit einem „automatisierten Bildausleser“, der das Internet durchsucht und Bilder mit menschlichen Gesichtern erkennt, aus sozialen Medien (zB Facebook, X) ausgelesen wurden. Der Bildausleser sammelt diese Bilder mit allen damit verbundenen Informationen (wie der Quelle des Bildes (URL), der Geolokalisierung und manchmal den Namen der einzelnen Personen). Die Gesichtsmerkmale werden dann aus den Bildern extrahiert und in mathematische Darstellungen umgewandelt, die für die Indexierung und den künftigen Vergleich mit Hashtags versehen werden. Wenn ein Nutzer das Bild einer Person in das KI-System hochlädt, wird dieses System bestimmen, ob dieses Bild mit einem Gesicht in der Datenbank übereinstimmt.[31] |

|

Art 5 Abs 1 lit e |

| Emotionserkennungssysteme am Arbeitsplatz oder in Bildungseinrichtungen |

|

|

Art 5 Abs 1 lit f |

| Biometrische Kategorisierung, Ableitung von sensiblen Daten (religiöse Weltanschauung, politische Einstellung) |

|

|

Art 5 Abs 1 lit g |

| Biometrische Echtzeit-Fernidentifizierungssysteme in öffentlich zugänglichen Räumen zu Strafverfolgungszwecken (zahlreiche Ausnahmen) |

|

|

Art 5 Abs 1 lit h |

Einige dieser Praktiken sind darüber hinaus bereits nach anderen Rechtsvorschriften verboten, so beispielsweise gewisse manipulative und täuschende Techniken als "dark patterns" nach dem Digital Services Act (gilt nur für bestimmte Plattform-Anbieter) oder die Verarbeitung biometrischer Daten zur Identifizierung einer Person nach Art 9 Abs 1 DSGVO, sofern keine der in Abs 2 genannten Ausnahmen vorliegt. Gemäß der neuen Plattformarbeitsrichtlinie[38], die bis Dezember 2026 in nationales Recht umzusetzen ist, ist überdies der Einsatz von automatisierten Überwachungs- und Entscheidungssystemen zur Erfassung personenbezogener Daten über den emotionalen oder psychischen Zustand einer Person (Emotionserkennung) verboten.[39]

Hochrisiko-KI-Systeme (Art 6 AI Act)

Einstufung

Der AI Act klassifiziert Hochrisiko-KI-Systeme in Art 6. Dabei kennt er zwei Varianten dieser Systeme, die in der Literatur - nicht aber im AI Act selbst - als "eingebettete" und "eigenständige" Hochrisiko-KI-Systeme bezeichnet werden. [40]

Darüber hinaus enthält Art 6 Abs 3 AI Act Ausnahmen von der Einstufung als Hochrisiko-KI-System.

Nach Art 6 Abs 5 AI Act hat die Kommission nach Konsultation des Europäischen Gremiums für Künstliche Intelligenz spätestens bis zum 2. Februar 2026 Leitlinien zur praktischen Umsetzung und eine umfassende Liste praktischer Beispiele für Anwendungsfälle für KI-Systeme, die hochriskant oder nicht hochriskant sind, bereitzustellen.

"Eingebettete" Hochrisiko-KI-Systeme (embedded high-risk AI systems) (Art 6 Abs 1 AI Act)

Nach Art 6 Abs 1 AI Act gilt zunächst ein KI-System als Hochrisiko-KI-System, wenn die zwei folgenden Bedingungen erfüllt sind:

- das KI-System soll als Sicherheitsbauteil eines unter die in Anhang I aufgeführten Harmonisierungsrechtsvorschriften der Union fallenden Produkts verwendet werden oder stellt selbst ein solches Produkt dar

- das Produkt, dessen Sicherheitsbauteil das KI-System ist, oder das KI-System selbst als Produkt muss im Rahmen dieser Harmonisierungsrechtsvorschriften einer Konformitätsbewertung durch Dritte unterzogen werden

Anhang I, Abschnitt A nennt dabei zwölf solche Harmonisierungsrechtsvorschriften (bezogen auf Maschinen, Spielzeug, Sportboote und Wassermotorräder, Aufzüge, Geräte und Schutzsysteme in explosionsgefährdeten Bereichen, Funkanlagen, Druckgeräte, Seilbahnen, persönliche Schutzausrüstungen, Geräte zur Verbrennung gasförmiger Brennstoffe, Medizinprodukte, In-vitro-Diagnostika).

Um diese Einstufung als Hochrisiko-KI-System durch ein Beispiel zu illustrieren:

| Beispiel |

|---|

| Software kann ein Medizinprodukt im Sinne der Medizinprodukteverordnung (MPVO) darstellen.[41]

Medizinprodukte ab Risikoklasse IIa, das heißt mittlerem Risiko (zB Diagnose oder Überwachung), unterliegen einer Konformitätsbewertung unter Einbeziehung einer "benannten Stelle", das heißt einer externen Konformitätsbewertungsstelle. Software als Medizinprodukt erfüllt damit - sofern sie unter die KI-Definition subsumiert werden kann - häufig beide Bedingungen:

Software als Medizinprodukt fällt somit gleichzeitig als Medizinprodukt unter die MPVO und, sofern die Software den KI-Begriff erfüllt, als Hochrisiko-KI-System unter den AI Act. |

"Eigenständige" Hochrisiko-KI-Systeme (stand-alone high-risk AI systems) (Art 6 Abs 2 AI Act)

Die zweite Variante von "eigenständigen" Hochrisiko-KI-Systemen wird durch Art 6 Abs 2 AI Act definiert, der dabei auf Anhang III verwiest. Dieser enthält acht Bereiche, untergliedert in konkretere Anwendungsfelder, die ebenfalls als hochriskant gelten: bspw biometrische Identifizierung, kritische Infrastrukturen, grundlegende öffentliche und private Dienste/Leistungen, Strafverfolgung, Migration, Asyl und Grenzkontrolle, Justiz und demokratische Prozesse.

Diese Liste kann dabei mittels delegierter Rechtsakte der Kommission geändert werten (Art 7 AI Act).

Ausnahmen (Art 6 Abs 3 AI Act)

Art 6 Abs 3 AI Act enthält als Abweichung Ausnahmen von der Einstufung als "eigenständiges" Hochrisiko-KI-System. Die Ausnahmen greifen dann, wenn sich zeigt, dass ein in Anhang III genanntes System kein erhebliches Risiko der Beeinträchtigung in Bezug auf die Gesundheit, Sicherheit oder Grundrechte natürlicher Personen birgt, indem es unter anderem nicht das Ergebnis einer Entscheidungsfindung, an der das System beteiligt ist, wesentlich beeinflusst.

Art 6 Abs 3 2. UAbs enthält dabei vier alternative Bedingungen, die die genannten Kriterien erfüllen. ErwGr 53 liefert konkretisierende Beispiele. Ein KI-System gilt somit als nicht hochriskant, wenn

- es dazu bestimmt ist, eine eng gefasste Verfahrensaufgabe durchzuführen (bspw ein KI-System, das unstrukturierte Daten in strukturierte Daten umwandelt)

- es dazu bestimmt ist, das Ergebnis einer zuvor abgeschlossenen menschlichen Tätigkeit zu verbessern (bspw KI-Systeme, deren Ziel es ist, die in zuvor verfassten Dokumenten verwendete Sprache zu verbessern, etwa den professionellen Ton, den wissenschaftlichen Sprachstil oder um den Text an einen bestimmten mit einer Marke verbundenen Stil anzupassen

- es dazu bestimmt ist, Entscheidungsmuster oder Abweichungen von früheren Entscheidungsmustern zu erkennen, und nicht dazu gedacht ist, die zuvor abgeschlossene menschliche Bewertung ohne eine angemessene menschliche Überprüfung zu ersetzen oder zu beeinflussen (bspw KI-Systeme, die in Bezug auf ein bestimmtes Benotungsmuster eines Lehrers dazu verwendet werden können, nachträglich zu prüfen, ob der Lehrer möglicherweise von dem Benotungsmuster abgewichen ist, um so auf mögliche Unstimmigkeiten oder Unregelmäßigkeiten aufmerksam zu machen)

- es dazu bestimmt ist, eine vorbereitende Aufgabe für eine Bewertung durchzuführen, die für die Zwecke der in Anhang III aufgeführten Anwendungsfälle relevant ist (bspw intelligente Lösungen für die Bearbeitung von Dossiers, wozu verschiedene Funktionen wie Indexierung, Suche, Text- und Sprachverarbeitung oder Verknüpfung von Daten mit anderen Datenquellen gehören)

Art 6 Abs 3 AI Act enthält dabei auch eine Rückausnahme, die einen Bezug zur DSGVO herstellt. Ein KI-System nach Anhang III gilt "immer dann als hochriskant, wenn es ein Profiling natürlicher Personen vornimmt." Als Profiling gilt dabei iSd Art 4 Abs 4 DSGVO jede automatisierte Verarbeitung personenbezogener Daten, die darin besteht, bestimmte persönliche Aspekte einer Person zu bewerten, insbesondere um Aspekte bezüglich Arbeitsleistung, Gesundheit, persönliche Vorlieben, Zuverlässigkeit, Verhalten etc. zu analysieren oder vorherzusagen.

Anforderungen an Hochrisiko-KI-Systeme (Art 8-15 AI Act)

Die Europäische Kommission hat im Rahmen von Public Consultations unter anderem auch Rückmeldungen zu Anforderungen an Hochrisiko-KI-Systeme eingeholt, die eine Grundlage für Leitlinien bilden sollen, welche im Februar 2026 veröffentlicht werden sollen.[42] Hochrisiko-KI-Systeme müssen einer Reihe von Anforderungen genügen, die in einem sog Konformitätsbewertungsverfahren geprüft werden, darunter:

Risikomanagementsystem (Art 9 AI Act)

Ein umfassendes Risikomanagementsystem muss eingerichtet, angewandt, dokumentiert und aufrechterhalten werden.

Dies umfasst die Ermittlung und Analyse von Risiken, ihre Abschätzung und Bewertung sowie die Ergreifung von Risikomanagementmaßnahmen und die Abwägung der Maßnahmen mit dem Restrisiko.

Vorgesehen sind auch Testverfahren.

Daten und Daten-Governance (Art 10 AI Act)

Hochrisiko-KI-Systeme müssen mit Trainings-, Validierungs- und Testdatensätzen entwickelt werden, die gewissen Qualitätskriterien entsprechen.

So müssen die Datensätze neben Verfahren in Bezug auf konzeptionelle Entscheidungen, die Datenerhebung und Aufbereitung (hinreichend) relevant und so weit wie möglich repräsentativ, fehlerfrei und vollständig sein und Verzerrungen (Bias) müssen vermieden werden.

Merkmale/Elemente, die für besonderen geografischen, kontextuellen, verhaltensbezogenen oder funktionalen Rahmenbedingungen typisch sind, müssen berücksichtigt werden.

In Bezug auf Bias ist auch eine Regelung zur Verarbeitung von besonders sensiblen personenbezogenen Daten zur Erkennung und Korrektur enthalten, die mit der DSGVO interagiert (Art 10 Abs 5 AI Act).

Technische Dokumentation (Art 11 AI Act)

Als Basis der Konformitätsbewertung muss eine technische Dokumentation erstellt werden, bevor das Hochrisiko-KI-System in Verkehr gebracht oder in Betrieb genommen wird. Diese ist stets auf dem neuesten Stand zu halten.

Aus ihr muss der Nachweis hervorgehen, wie das Hochrisiko-KI-System die Anforderungen der Art 8 bis 15 AI Act erfüllt.

Durch die Dokumentation sollen den zuständigen nationalen Behörden und den notifizierten Stellen alle Informationen zur Verfügung stehen, die erforderlich sind, um zu beurteilen, ob das KI-System diese Anforderungen erfüllt.

KMUs können diese Dokumentation in vereinfachter Weise bereitstellen.

Aufzeichnungspflichten (Art 12 AI Act)

Hochrisiko-KI-Systeme müssen mit Funktionsmerkmalen konzipiert und entwickelt werden, die eine automatische Aufzeichnung von Vorgängen und Ereignissen („Protokollierung“) während des Betriebs der Hochrisiko-KI-Systeme ermöglichen.

Die Protokollierung (zB von Situationen, die dazu führen können, dass das System ein Risiko birgt oder dass es zu einer wesentlichen Änderung kommt) gewährleistet, dass das Funktionieren des KI-Systems während seines gesamten Lebenszyklus rückverfolgbar ist.

Transparenz und Bereitstellung von Informationen für die Betreiber (Art 13 AI Act)

Hochrisiko-KI-Systeme werden so konzipiert und entwickelt, dass ihr Betrieb hinreichend transparent ist, damit die Nutzer die Ergebnisse des Systems angemessen interpretieren und verwenden können.

Auch müssen den Nutzern/Betreibern entsprechende Betriebsanleitungen (zB zu Merkmalen, Fähigkeiten und Leistungsgrenzen des Hochrisiko-KI-Systems) zur Verfügung gestellt werden.

Menschliche Aufsicht (Art 14 AI Act)

Hochrisiko-KI-Systeme müssen so konzipiert und entwickelt werden, dass sie während der Dauer der Verwendung des KI-Systems von natürlichen Personen wirksam beaufsichtigt werden können.

Dies dient der Verhinderung/Minimierung der Risiken für Gesundheit, Sicherheit oder Grundrechte und erfordert bspw die Möglichkeit die Fähigkeiten und Grenzen des KI-Systems angemessen und verstehen und seinen Betrieb zu überwachen, Maßnahmen gegen automation bias und die Option, das System nicht zu verwenden, seine Ausgabe außer Acht zu lassen oder in den Betrieb einzugreifen bzw ihn mit einer "Stopptaste" zu unterbrechen.

Genauigkeit, Robustheit und Cybersicherheit (Art 15 AI Act)

Hochrisiko-KI-Systeme müssen so konzipiert und entwickelt werden, dass sie ein angemessenes Maß an Genauigkeit, Robustheit und Cybersicherheit erreichen und in dieser Hinsicht während ihres gesamten Lebenszyklus beständig funktionieren.

Dies umfasst somit Maßnahmen in Hinblick auf innere Fehlerquellen (Performanzmetriken für Genauigkeit, Widerstandsfähigkeit gegenüber Fehlern, Störungen, Unstimmigkeiten für Robustheit; Maßnahmen gegen Rückkopplungsschleifen), als auch Angriffe von Außen (Cybersicherheit).

Pflichten für Anbieter von Hochrisiko-KI-Systemen (Art 16-21 AI Act)

Anbieter von Hochrisiko-KI-Systemen müssen als wichtigste Pflichten ua (Art 16 AI Act):

- sicherstellen, dass diese Systemen die Anforderungen der Art 8-15 AI Act erfüllen

- damit verbunden sicherstellen, dass sie einem Konformitätsbewertungsverfahren unterzogen werden (resultierend in einer Konformitätserklärung und einer CE-Kennzeichnung)

- über ein Qualitätsmanagementsystem (Art 17 AI Act) verfügen (ua Konzept zur Einhaltung der Regulierungsvorschriften, Techniken, Verfahren und systematische Maßnahmen für die Entwicklung, Qualitätskontrolle und Qualitätssicherung des Hochrisiko-KI-Systems; Untersuchungs-, Test- und Validierungsverfahren; Systeme und Verfahren für das Datenmanagement)

- Dokumentation (Art 18 AI Act) und Protokolle (Art 19 AI Act) aufbewahren

- einer Registrierungspflicht nachkommen (Art 49 AI Act) und

- erforderliche Korrekturmaßnahmen ergreifen und Informationen bereitstellen (Art 20 AI Act)

Konformitätsbewertungsverfahren (Art 43 AI Act)

Zentrale Anbieterpflicht ist die Durchführung eines sog Konformitätsbewertungsverfahrens. In diesem Verfahren wird überprüft, ob das Hochrisiko-KI-System die Anforderungen nach Art 8-15 AI Act erfüllt (Art 3 Z 20 AI Act).

Dabei existieren zwei verschiedene Varianten dieses Verfahrens (Art 43 AI Act).

Diese unterscheiden sich primär darin, ob eine notifizierte Stelle, das heißt eine Stelle, die Konformitätsbewertungstätigkeiten einschließlich Prüfungen, Zertifizierungen und Inspektionen durchführt und dabei als Dritte auftritt und die nach dem AI Act "notifiziert" wurde (Art 3 Z 21, 22 AI Act). Die notifizierten Stellen finden sich in einer entsprechenden Datenbank.

- interne Kontrolle (Anhang VI): Eigenzertifizierung, ohne Beiziehung einer notifizierten Stelle (vorgesehen für eigenständige Hochrisiko-KI-Systeme mit Ausnahme des Bereiches Biometrie)

- Bewertung des Qualitätsmanagementsystems und der Bewertung der technischen Dokumentation unter Beteiligung einer notifizierten Stelle (Anhang VII) (primär vorgesehen für eingebettete Hochrisiko-KI-Systeme)

Bei eingebetteten Hochrisiko-KI-Systemen ist vorgesehen, dass die nach dem Harmonisierungsrechtsakt einschlägige Konformitätsbewertung (zB nach Medizinprodukteverordnung) durchgeführt wird und die Aspekte des AI Act in dieses Verfahren einbezogen werden (Art 43 Abs 3 AI Act). Ein solches "kombiniertes" Verfahren kann für einer notifizierten Stelle durchgeführt werden, sofern diese die notwendige Expertise, etc aufweist.

Bei wesentlichen Änderungen des Systems ist eine erneute Durchführung notwendig. Dies gilt für Systeme, die im Betrieb weiterlernen, nicht für vorab durch den Anbieter festgelegte Änderungen des Systems und seiner Leistung (Art 43 Abs 4 AI Act).

Der Anbieter hat daraufhin eine EU-Konformitätserklärung (Art 47 AI Act) auszustellen, eine CE-Kennzeichnung (Art 48 AI Act) anzubringen und das (selbständige) Hochrisiko-KI-System in einer Datenbank zu registrieren (Art 49 AI Act).

Pflichten für Betreiber von Hochrisiko-KI-Systemen

Betreiberpflichten nach Art 26 AI Act

Betreiber von Hochrisiko-KI-Systemen unterliegen im Vergleich zu Anbietern nur eingeschränkten Pflichten. Sie müssen ua

- geeignete technische und organisatorische Maßnahmen treffen, um sicherzustellen, dass sie KI-Systeme entsprechend den beigefügten Betriebsanleitungen verwenden

- die menschliche Aufsicht an natürliche Personen übertragen, die über die erforderliche Kompetenz, Ausbildung und Befugnis ("KI-Kompetenz" nach Art 4[43]) verfügen und ihnen die erforderliche Unterstützung zukommen lassen.

- soweit die Eingabedaten ihrer Kontrolle unterliegen dafür sorgen, dass diese der Zweckbestimmung des Hochrisiko-KI-Systems entsprechend und ausreichend repräsentativ sind

- den Betrieb des Hochrisiko-KI-Systems anhand der Betriebsanleitung überwachen und gegebenenfalls Anbieter iSv Art 72 AI Act informieren. Besteht Grund zur Annahme, dass die Verwendung gemäß der Betriebsanleitung dazu führen kann, dass dieses Hochrisiko-KI-System ein Risiko im Sinne des Art 79 Abs 1 AI Act birgt, so informieren Betreiber unverzüglich den Anbieter oder Händler und die zuständige Marktüberwachungsbehörde und setzen die Verwendung dieses Systems aus. Ähnliches gilt bei Feststellung eines schwerwiegenden Vorfalls.

- Aufbewahrung von automatisiert erzeugten Protokollen für einen Zeitraum von zumindest 6 Monaten (wobei hier entgegenstehende datenschutzrechtliche Regelungen vorgehen würden[44])

- Information der Arbeitnehmervertreter und betroffenen Arbeitnehmer, vor Verwendung oder Inbetriebnahme des Hochrisiko-KI-Systems am Arbeitsplatz. Dies umfasst sowohl den Einsatz von "eingebetteten" als auch "eigenständigen" Hochrisiko-KI-Systemen. Weiters sind die Mitwirkungspflichten des Betriebsrats zu berücksichtigen (vgl §§ 96 f ArbVG). Nicht umfasst sind wahrscheinlich Informationspflichten gegenüber Bewerbern, da diese tendenziell nicht unter den von dieser Bestimmung geforderten "Arbeitnehmer-Begriff" fallen.

- Information an natürliche Personen, dass sie der Verwendung eines Hochrisiko-KI-Systems unterliegen, wenn das Hochrisiko-KI-Systeme natürliche Personen betreffende Entscheidungen trifft oder bei solchen Entscheidungen Unterstützung leistet. Diese Bestimmung gilt lediglich für den Einsatz von "eigenständigen" Hochrisiko-KI-Systemen nach Art 6 Abs 2 iVm Anhang III.Die danach mitzuteilende Information sollte die Zweckbestimmung und die Art der getroffenen Entscheidung beinhalten (vgl ErwGr 93) sowie - nach einer hier vertretenen Auffassung - eine vorab Information über das Recht auf Erklärung nach Art 86 AI Act, welches von KI-Entscheidungen Betroffenen das Recht zugesteht, unter gewissen Voraussetzungen vom Betreiber eine klare und aussagekräftige Erläuterung zur Rolle des KI-Systems im Entscheidungsprozess sowie zu den wichtigsten Elementen der getroffenen Entscheidung zu erhalten.[45]

Grundrechte-Folgenabschätzung (Art 27 AI Act)

Als Gegenstück zum Risikomanagement (Art 9 AI Act), das Anbieter von Hochrisiko-KI-Systemen betrifft, müssen gewisse Betreiber[46] von Hochrisiko-KI-Systemen vor der ersten Verwendung eine Abschätzung der Risiken auf Grundrechte durchführen (Art 27 Abs 1 AI Act).[47]

Die Abschätzung umfasst dabei

- eine Beschreibung der Verfahren, bei denen das Hochrisiko-KI-System verwendet wird

- eine Beschreibung des Zeitraums und der Häufigkeit der Verwendung

- die Kategorien der natürlichen Personen und Personengruppen, die von seiner Verwendung betroffen sein könnten

- die spezifischen Schadensrisiken, die sich auf die ermittelten Kategorien natürlicher Personen oder Personengruppen auswirken könnten

- eine Beschreibung der Umsetzung von Maßnahmen der menschlichen Aufsicht

- die Maßnahmen, die im Falle des Eintretens dieser Risiken zu ergreifen sind.

Das Büro für KI wird dabei ein Muster für einen Fragebogen entwickeln, um dieser Pflicht in vereinfachter Weise nachkommen zu können (Art 27 Abs 5 AI Act).

Art 27 Abs 4 macht überdies die Verzahnung der Grundrechte-Folgenabschätzung (GRFA) mit anderen Folgenabschätzungen deutlich und schreibt bspw vor, dass bei Vorliegen einer Datenschutz-Folgenabschätzung nach Art 35 DSGVO die GRFA diese ergänzen bzw in diese integriert werden solle.[48]

Sowohl die Verpflichtungen nach Art 26 als auch die Durchführung einer GRFA nach Art 27 treffen den Betreiber unabhängig davon, ob jemand (bspw Betroffene) deren Einhaltung einfordern. Im Unterschied dazu enthält der AI Act in den Artt 85 ff sog "Betroffenenrechte", die aktiv von betroffenen Personen geltend zu machen sind. Dazu zählt insbesondere das Recht auf Erklärung nach Art 86, welches das einzige Betroffenenrecht darstellt, das direkt gegen den Betreiber durchsetzbar ist.

Änderung der Rolle des Akteurs/Verantwortlichkeit entlang der Wertschöpfungskette (Art 25 AI Act)

Die Einstufung als Betreiber oder Anbieter ist dabei nicht statistisch, wie Art 25 AI Act zeigt. Dieser normiert Fälle, in denen Betreiber (und Händler, Einführer oder sonstige Dritte) als Anbieter eines Hochrisiko-KI-Systems gelten und damit auch den Anbieterpflichten (Art 16 AI Act) unterliegen.

Ein solcher "Rollenwechsel" findet in folgenden Konstellationen statt (Art 25 Abs 1 AI Act):

- wenn die genannten Personen ein bereits in Verkehr gebrachtes oder in Betrieb genommenes Hochrisiko-KI-System mit ihrem Namen oder ihrer Handelsmarke versehen, unbeschadet vertraglicher Vereinbarungen, die eine andere Aufteilung der Pflichten vorsehen;

- wenn sie eine wesentliche Veränderung eines Hochrisiko-KI-Systems, das bereits in Verkehr gebracht oder in Betrieb genommen wurde, so vornehmen, dass es weiterhin ein Hochrisiko-KI-System gemäß Art 6 AI Act bleibt;

- wenn sie die Zweckbestimmung eines KI-Systems, das nicht als hochriskant eingestuft wurde und bereits in Verkehr gebracht oder in Betrieb genommen wurde, so verändern, dass das betreffende KI-System zu einem Hochrisiko-KI-System im Sinne von Art 6 AI Act wird.

In diesen Szenarien gilt der ursprüngliche Anbieter (Erstanbieter) nicht mehr als Anbieter dieses spezifischen KI-Systems (Art 25 Abs 2 AI Act). Der Erstanbieter hat jedoch mit dem neuen Anbieter zusammenzuarbeiten, insb Informationen zur Verfügung zu stellen, für technischen Zugang und sonstige Unterstützung zu sorgen.[49]

| Hinweis: |

|---|

| Aufgrund von Art 25 AI Act muss beachtet werden, dass die Rollenverteilung eine dynamische und nicht statische ist. So könnte zB ein Betreiber eines Large Language Models, der dieses zur Generierung von medizinischen Diagnosen verwendet, wenn diese Verwendung entgegen der Zweckbestimmung des (ursprünglichen) Anbieters erfolgt, durch diese Verwendung zum neuen Anbieter werden und auch dessen Pflichten übernehmen. Auch ein Zusammentreffen der Rolle von Anbieter und Betreiber in einem Akteur ist möglich. |

Transparenzpflichten (Art 50 AI Act)

Unabhängig von der Risikoeinstufung eines KI-Systems sieht Art 50 AI Act Transparenzpflichten für gewisse KI-Systeme vor. Die Informationen müssen spätestens zum Zeitpunkt der ersten Interaktion oder Aussetzung in klarer und eindeutiger Weise bereitgestellt werden sowie den Anforderungen an die Barrierefreiheit genügen.

- Anbieter haben bei KI-Systemen, die für die direkte Interaktion mit natürlichen Personen bestimmt sind (zB Chatbots, Sprachassistenten, Social Bots), sicherzustellen, dass diese so konzipiert und entwickelt werden, dass die betreffenden natürlichen Personen informiert werden, dass sie mit einem KI-System interagieren.[50] Diese Pflicht kann entfallen, wenn die Interaktion mit dem KI-System aus Sicht einer angemessen informierten, aufmerksamen und verständigen Person offensichtlich ist oder beim Einsatz von KI-Systemen, die für die Strafverfolgung zugelassen sind.[51]

| Beispiele[52] |

|---|

| Chatbots können durch einen textlichen Hinweis zu Beginn des Gesprächs oder ein dauerhaft angezeigtes grafisches Symbol vorgestellt werden.

Bei Voicebots kommt eine der Interaktion vorausgehende Ansage, welche auf den KI-Einsatz hinweist, in Betracht. Social Bots können eine Information vor und mit jeder Interaktion des Bots in sozialen Netzwerken erfordern, da das System stets mit einem neuen Personenkreis in Interaktion tritt (zB AI-Influencer). |

- Anbieter von KI-Systemen die synthetische Audio-, Bild-, Video- oder Textinhalte erzeugen, müssen sicherstellen, dass die Ausgaben des KI-Systems in einem maschinenlesbaren Format gekennzeichnet und als künstlich erzeugt oder manipuliert erkennbar sind.[53] [54] Mögliche Methoden wären bspw Wasserzeichen, Metadatenidentifizierungen, Kryptografische Methoden (zB "Hashing"), Protokollierungsmethoden oder Fingerabdrücke.[55]

- Betreiber eines Emotionserkennungssystems oder eines Systems zur biometrischen Kategorisierung müssen die davon betroffenen natürlichen Personen über den Betrieb des Systems informieren und personenbezogene Daten datenschutzkonform[56] verarbeiten.[57]

- Betreiber eines KI-Systems, das Bild-, Ton- oder Videoinhalte erzeugt oder manipuliert, die ein Deepfake sind, müssen offenlegen, dass die Inhalte künstlich erzeugt oder manipuliert wurden.[58] Denkbar ist bspw eine Umsetzung in Form eines sichtbaren Wasserzeichens, eines textlichen Hinweises, durch Hinzufügen von sog C2PA-Content Credentials[59] oder bei Audioinhalten durch eine Ansage zu Beginn des Audioinhalts.[60]

- Betreiber eines KI-Systems, das Text erzeugt oder manipuliert, der veröffentlicht wird, um die Öffentlichkeit über Angelegenheiten von öffentlichem Interesse zu informieren, müssen offenlegen, dass der Text künstlich erzeugt oder manipuliert wurde.[61] Diese Verpflichtung entfällt, wenn die betreffenden Inhalte vor ihrer Veröffentlichung einer menschlichen oder redaktionellen Kontrolle unterzogen wurden und eine Person die redaktionelle Verantwortung dafür trägt. Da die Anforderungen an die menschliche bzw redaktionelle Kontrolle nicht konkretisiert werden, unterwerfen sich bspw im journalistischen Bereich zahlreiche Medien freiwilligen Leitlinien (so etwa die Leitlinien des Medienrats der Bayerischen Landeszentrale für neue Medien (BLM) zum Einsatz von Künstlicher Intelligenz im Journalismus).[62]

KI-Systeme mit minimalem Risiko

Für KI-Systeme, die sich nicht unter die aufgezählten Bestimmungen (verbotene Praktiken, Hochrisiko-KI-Systeme, Transparenzpflichten) einteilen lassen, teilweise als "KI-Systeme mit minimalem Risiko" bezeichnet, sieht der AI Act keine zusätzlichen Pflichten vor. Andere nationale oder unionsrechtliche Vorschriften wie die DSGVO können dennoch auf diese Systeme anwendbar sein. Auf freiwilliger Ebene ist jedoch auch bei Systemen, die kein hohes Risiko bergen, eine (teilweise) Unterwerfung unter den AI Act möglich. Dies soll durch die Aufstellung von sog "Verhaltenskodizes" gefördert werden (Art 95 AI Act).

GPAI-Modelle (Art 51 ff AI Act)

Als Reaktion auf den sprunghaften Durchbruch generativer KI-Modelle, die für viele verschiedene Zwecke eingesetzt werden können, in den Jahren 2022 und 2023 wurden unter Durchbrechung des bisherigen zweck- und risikoorientierten Regelungsansatzes im Entwurfsstadium des AI Act nachträglich Regeln für solche Modelle eingefügt. Diese sind seit 2. August 2025 in Geltung. Ein GPAI-Modell (in früheren Entwurfsfassungen foundation model/Basismodell) ist dabei in Art 3 Z 63 AI Act definiert als ein KI-Modell, das

- das eine erhebliche allgemeine Verwendbarkeit aufweist,

- in der Lage ist, ein breites Spektrum unterschiedlicher Aufgaben kompetent zu erfüllen, und

- das in eine Vielzahl nachgelagerter Systeme oder Anwendungen integriert werden kann.

In den von der EU-Kommission im Juli 2025 veröffentlichten Leitlinien zu GPAI-Modellen werden eine kumulierte Menge der für das Training verwendeten Berechnungen gemessen in Gleitkommaoperationen (floating point operations [FLOPs]),[63] von mehr als 1023 und die Fähigkeit, geschriebene oder gesprochene Sprache (aber auch Bilder oder Videos aus Text) zu generieren, als Anhaltspunkte für das Vorliegen eines GPAI-Modells angegeben, es sei denn, das Modell erfüllt die oben angegebenen Kriterien der Allgemeinheit nicht (zB weil es spezifisch nur für die Transkription von Sprache in Text trainiert wurde).[64] Somit ist davon auszugehen, dass die üblichen LLMs, wie die GPT-Serie von OpenAI, die Gemini-Serie von Google oder die Claude-Serie von Anthropic als GPAI-Modelle im Sinne dieser Definition einzustufen sind.

Die Befugnisse für die Aufsicht, Ermittlung, Durchsetzung und Überwachung in Bezug auf Anbieter von GPAI-Modellen werden (ausschließlich) der Kommission zugewiesen und in den Art 88-94 AI Act abweichend geregelt.

Abgrenzung der Rollen entlang der Wertschöpfungskette

In Bezug auf GPAI-Modelle können (anknüpfend an die allgemeinen Rollendefinitionen des AI Act) folgende Rollen unterschieden werden:

- Anbieter (Providers) von GPAI-Modellen: Entwickeln ein GPAI-Modell oder lassen es entwickeln und bringen es ihrem eigenen Namen oder ihrer Handelsmarke in Verkehr oder nehmen es unter ihrem eigenen Namen oder ihrer Handelsmarke in Betrieb, sei es entgeltlich oder unentgeltlich (Art 3 Z 3 AI Act);[65] sie treffen primär die nachfolgend beschriebenen Pflichten.

- Nachgelagerte Modifizierer (Downstream Modifiers) von GPAI-Modellen: Fine-tunen/modifizieren[66] bestehende GPAI-Modelle anderer Anbieter; laut der Kommission ist nicht jeder Modifizierer dadurch gleich als Anbieter des modifizierten GPAI-Modells anzusehen, dies jedoch dann, wenn die Modifikation des GPAI-Modells zu einer wesentlichen Änderung der Universalität, der Leistungsfähigkeit oder des systemischen Risikos des GPAI-Modells führt, wobei als Indiz dafür gilt, dass die Anzahl der Berechnungen für die Modifikation ein Drittel jener für das Training des ursprünglichen GPAI-Modells übersteigt.[67]

- Nachgelagerte Anbieter (Downstream Providers) von KI-Systemen: Integrieren GPAI-Modelle in KI-Systeme; ein wesentlicher Zweck der Regulierung von GPAI-Modellen ist, dass nachgelagerte Anbieter, ein GPAI-Modell in ihr KI-System integrieren, Informationen über dieses Modell erhalten und darauf basierend ihren eigenen Verpflichtungen (nach den allgemeinen Regeln des AI Act für KI-Systeme) nachkommen zu können.

- Betreiber (Deployers): Verwenden ein KI-System im praktischen Einsatz.

Differenzierung: GPAI-Modelle ohne/mit systemischem Risiko (Art 51-52 AI Act)

Wie bereits in Bezug auf den Anwendungsbereich erläutert muss zwischen KI-Systemen und KI-Modellen unterschieden werden. Ein KI-Modell ist dabei nur ein Bestandteil eines KI-Systems, weitere Komponenten wie eine Nutzerschnittstelle sind erforderlich, damit ein Modell zu einem KI-System wird (ErwGr 97 AI Act). Bspw bietet ChatGPT eine Nutzerschnittstelle, um auf diverse dahinterstehende GPT-Modelle zurückzugreifen. Während KI-Systeme der Hauptgegenstand der Regulierung durch den AI Act sind (risikobasierten Ansatz), unterliegen auf Ebene der Modelle nur GPAI-Modelle einer direkten Regulierung (Art 51 ff AI Act).

Diese Regulierung unterscheidet zwischen GPAI-Modellen ohne und GPAI-Modellen mit systemischem Risiko. Ein solches systemisches Risiko liegt vor (Art 51 AI Act),

- wenn das Modell über "Fähigkeiten mit hohem Wirkungsgrad" verfügt, die mithilfe geeigneter technischer Instrumente und Methoden, einschließlich Indikatoren und Benchmarks, bewertet werden. Dies wird angenommen, wenn die kumulierte Menge der für sein Training verwendeten Berechnungen, mehr als 1025 FLOPs beträgt.[68] Liegen solche Fähigkeiten mit hohem Wirkungsgrad vor, hat der Anbieter die Kommission (unverzüglich) zu informieren (Art 52 AI Act). Oder

- wenn die Kommission in einer Entscheidung festgestellt hat, dass es über solche Fähigkeiten oder eine solche Wirkung verfügt (unter Einbeziehung der Kriterien in Anhang XIII bspw Anzahl der Parameter, Größe des Datensatzes, Multimodalität, etc).

Pflichten für Anbieter von GPAI-Modellen (Art 53 AI Act)

Anbieter von GPAI-Modellen (ohne systemisches Risiko) müssen (Art 53 Abs 1 AI Act):

- eine technische Dokumentation des Modells erstellen und aktualisieren (Mindestelemente in Anhang XI).[69] Diese muss auf Anfrage Behörden zur Verfügung gestellt werden

- Informationen und die Dokumentation (Mindestelemente in Anhang XII)[70] erstellen und aktualisieren und sie Anbietern von KI-Systemen zur Verfügung stellen, die beabsichtigen, das KI-Modell mit allgemeinem Verwendungszweck in ihre KI-Systeme zu integrieren. Diese Informationen und die Dokumentation müssen die Anbieter von KI-Systemen in die Lage versetzen, die Fähigkeiten und Grenzen des KI-Modells mit allgemeinem Verwendungszweck gut zu verstehen und ihren Pflichten gemäß dem AI Act nachzukommen.

- eine Strategie zur Einhaltung des Urheberrechts der Union und damit zusammenhängender Rechte auch durch modernste Technologien, auf den Weg bringen

- eine hinreichend detaillierte Zusammenfassung der für das Training des GPAI-Modells verwendeten Inhalte erstellen und veröffentlichen

Die Pflichten 1 und 2 "gelten nicht für Anbieter von KI-Modellen, die im Rahmen einer freien und quelloffenen Lizenz bereitgestellt werden, die den Zugang, die Nutzung, die Änderung und die Verbreitung des Modells ermöglicht und deren Parameter, einschließlich Gewichte, Informationen über die Modellarchitektur und Informationen über die Modellnutzung, öffentlich zugänglich gemacht werden. Diese Ausnahme gilt nicht für KI-Modellen [sic!] mit allgemeinem Verwendungszweck mit systemischen Risiken." (Art 53 Abs 2 AI Act) In den Leitlinien der Kommission ist die (strenge) Auslegung der einzelnen Kriterien dieser Definition ausführlich dargelegt.[65]

Pflichten für Anbieter von GPAI-Modellen mit systemischem Risiko (Art 55 AI Act)

Anbieter von GPAI-Modellen mit systemischem Risiko müssen (zusätzlich) (Art 55 Abs 1 AI Act):

- eine Modellbewertung mit standardisierten Protokollen und Instrumenten, die dem Stand der Technik entsprechen, durchführen (inklusive der Durchführung und Dokumentation von Angriffstests beim Modell gehören, um systemische Risiken zu ermitteln und zu mindern)

- mögliche systemische Risiken auf Unionsebene bewerten und mindern

- einschlägige Informationen über schwerwiegende Vorfälle und mögliche Abhilfemaßnahmen erfassen und dokumentieren und die Behörden darüber unterrichten

- ein angemessenes Maß an Cybersicherheit für die Modelle und die physische Infrastruktur des Modells gewährleisten

Details zur Umsetzung insbesondere dieser risiko- und sicherheitsbezogenen Pflichten sind im Kapitel Sicherheit des General-Purpose AI Code of Practice festgelegt. Siehe dazu sogleich.

Praxisleitfäden (codes of practice) (Art 56 AI Act)

Die genannten Pflichten sollen dabei durch sog Praxisleitfäden auf Unionsebene konkretisiert werden, die unter Berücksichtigung internationaler Ansätze zur ordnungsgemäßen Anwendung des AI Act beitragen sollen.

Für die Ausarbeitung solcher Leitfäden können alle Anbieter von GPAI-Modellen sowie die einschlägigen zuständigen nationalen Behörden ersucht werden, sich an der Ausarbeitung von Praxisleitfäden zu beteiligen. Organisationen der Zivilgesellschaft, die Industrie, die Wissenschaft und andere einschlägige Interessenträger wie nachgelagerte Anbieter und unabhängige Sachverständige können den Prozess ebenfalls unterstützen (Art 56 Abs 3 AI Act).

Am 10. Juli 2025 wurde der Praxisleitfaden "General-Purpose AI Code of Practice" veröffentlicht und von der EU-Kommission und vom KI-Gremium am 1. August 2025 gem Art 56 Abs 6 AI Act als angemessen bewertet.[71] Zu diesem wurde auch eine FAQ-Seite veröffentlicht. Auch ein Musterdokumentationsformular für Modelle ist Teil des GPAI Code of Practice. Zusätzlich hat die EU-Kommission am 18. Juli 2025 auch Leitlinien zum Umfang der Verpflichtungen für Anbieter von KI-Modellen mit allgemeinem Verwendungszweck nach dem AI Act veröffentlicht.

Für Anbieter von GPAI-Modellen, die den GPAI Code of Practice unterzeichnen und diesen einhalten, können dadurch nachweisen, dass sie ihre Pflichten nach Art 53 Abs 1 und Art 55 Abs 1 AI Act erfüllen.[72] Damit sollen Rechtssicherheit geschaffen sowie Compliance und Vollzug vereinfacht werden. Es handelt sich dabei aber um eine freiwillige Maßnahme und es steht Anbietern von GPAI-Modellen somit frei, die entsprechenden Bestimmungen des AI Act auch auf andere Weise umzusetzen.

Auf der oben verlinkten Website des GPAI Code of Practice ist angegeben, welche Anbieter von GPAI-Modellen diesen unterzeichnet haben. Darunter finden sich die meisten Anbieter der gängigen LLMs, wie Anthropic, Google, OpenAI und Mistral AI.

Durchsetzung/Rechtsbehelfe (Art 85-87 AI Act)

Der AI Act normiert nur wenige Rechtsbehelfe für Betroffene.

| Hinweis: |

|---|

| In Bezug auf mögliche Rechtsbehelfe muss der AI Act, der diesbezüglich nur eingeschränkte Möglichkeiten bereithält, im Zusammenhang mit der PLD gesehen werden. |

Recht auf Beschwerde bei der Marktüberwachungsbehörde (Art 85 AI Act)

Zunächst kann jede natürliche oder juristische Person, die Grund zu der Annahme hat, dass gegen die Bestimmungen des AI Act verstoßen wurde, unbeschadet anderer Rechtsbehelfe, bei der betreffenden Marktüberwachungsbehörde Beschwerden einreichen. Diese Beschwerden werden für die Zwecke der Durchführung von Marktüberwachungstätigkeiten berücksichtigt.

Stand November 2025 wurde in Österreich noch keine Behörde als zuständige Marktüberwachungsbehörde eingerichtet oder benannt. Bereits mit 2. November 2024 sind jedoch einige Behörden und öffentliche Stellen im Grundrechtsbereich gemäß Art 77 Abs 2 mit Aufsichts- und Durchsetzungsbefugnissen für Grundrechte insb im Zusammenhang mit Hochrisiko-KI ausgestattet worden, darunter die Volksanwaltschaft, die Datenschutzbehörde, die Arbeiterkammer, die Gleichbehandlungskommission, die Behindertenanwaltschaft, die KommAustria uvm.[73] Dabei treffen auch die (künftig) zuständige Marktüberwachungsbehörde umfassende Kooperationspflichten, wie etwa die Meldung schwerwiegender Grundrechtsvorfälle in diesem Kontext an die genannten Einrichtungen (vgl Art 73 Abs 7 und Art 79 Abs 2 AI Act).[74] Dazu hat die Kommission entsprechende Leitlinien zu veröffentlichen, die sich gerade in Ausarbeitung befinden.[75]

Recht auf Erläuterung der Entscheidungsfindung im Einzelfall (Art 86 AI Act)

Zweitens haben Personen,

- die von einer Entscheidung im Einzelfall betroffen sind,

- die der Betreiber auf der Grundlage der Ausgaben eines in Anhang III aufgeführten Hochrisiko-KI-Systems getroffen hat (somit nur eigenständige Hochrisiko-KI-Systeme;[76] eingebettete Hochrisiko-KI-Systeme wie Medizinprodukte sind nicht erfasst)

- und die rechtliche Auswirkungen hat oder

- sie in ähnlicher Art erheblich auf eine Weise beeinträchtigt, die ihrer Ansicht nach ihre Gesundheit, ihre Sicherheit oder ihre Grundrechte beeinträchtigt,

das Recht, vom Betreiber eine klare und aussagekräftige Erläuterung zur Rolle des KI-Systems im Entscheidungsprozess und zu den wichtigsten Elementen der getroffenen Entscheidung zu erhalten (Recht auf Erläuterung der Entscheidungsfindung im Einzelfall gemäß Art 86 Abs 1 AI Act oder auch gemeinhin als "Recht auf Erklärung" bezeichnet).[77] Dabei ist es unerheblich, ob das KI-System die Entscheidung gänzlich autonom getroffen hat oder unterstützend beteiligt war, es darf lediglich keine untergeordnete Rolle im Entscheidungsprozess gespielt haben. Steht das Recht auf Erklärung zu, hat die betroffene Person einerseits das Recht, eine Erklärung über die Rolle des KI-Systems im Entscheidungsprozess zu verlangen, worunter einerseits Informationen über die zentralen Aufgaben des Systems im Entscheidungsprozess fallen (zB Zielgruppenselektion, Datenanalyse, Vorgabe der Entscheidung usw.) und andererseits auch der Grad dessen Beteiligung (gering, mittel, hoch), was umgekehrt auch den Grad menschlicher Beteiligung an der Entscheidungsfindung erfordert. Weiters sind die wichtigsten Elemente der Entscheidung zu beauskunften, beispielsweise Eingabedaten, wesentliche Entscheidungsgründe, kontrafaktische Erklärungen (inwiefern hätten andere Parameter zu einer anderen Entscheidungen geführt), die Auswirkungen der Entscheidung, die Gewichtung der einzelnen Kriterien und die Verarbeitungslogik (Informationen über die grobe Funktionsweise des KI-Systems, keine komplette Offenlegung des algorithmischen Codes). Weiters muss die Erklärung präzise, korrekt, verständlich, nicht zu technisch (keine komplexen mathematischen Formeln), aber dennoch vollständig sein.[78] Letzter Referenzpunkt ist stets, ob die betroffene Person auf Basis der erlangten Informationen weitere Rechte geltend machen kann, da das Recht auf Erklärung auch oft als "Türöffner" für die Geltendmachung weiterer Rechte dient (so wird bspw eine Klage wegen Diskriminierung in einem Entscheidungsprozess erst erhoben werden können, wenn die betroffene Person genügend Informationen hat, um die Diskriminierung darzulegen, bspw die Gewichtung von bestimmten persönlichen Merkmalen, die ausschlaggebend für die Entscheidung war).

Es handelt sich somit um ein nachgelagertes bzw ex post Recht, das nicht nur globale, abstrakte Systemerklärungen erfordert, sondern auch lokale, einzelfallbezogene Auskünfte umfasst, damit die betroffene Person die Informationen wirksam nutzbar machen kann . Das Recht auf Erklärung steht Betroffenen gegenüber Betreibern und nicht gegenüber Anbietern zu, wobei letztere wiederum Betreibern entsprechende Betriebsanleitungen bereitzustellen haben (Art 13 AI Act).

Das Recht auf Erklärung gilt nicht, sofern Ausnahmen nach Unionsrecht oder nationalem Recht bestehen (Art 86 Abs 2). Zu denken wäre hier etwa an Beschränkungen der Informationspflicht aufgrund geschützter Betriebs- oder Geschäftsgeheimnisse, wobei diese nicht zu einer pauschalen Auskunftsverweigerung führen dürfen. Art 86 Abs 1 gilt überdies nur insoweit, als dieses Recht nicht anderweitig im Unionsrecht festgelegt ist (Art 86 Abs 3 AI Act). In Hinblick auf diese Subsidiarität ist insbesondere an das Auskunftsrecht nach Art 15 DSGVO (iVm Art 22 DSGVO) zu denken.

Das Recht auf Erklärung ist immer dann relevant, wenn Unternehmen, Behörden etc. KI in Entscheidungsfindungsprozessen einsetzen, die Auswirkungen auf bestimmte Personen(-gruppen) haben. Zu denken ist etwa an KI-basierte Entscheidungen über die Vergabe von Krediten, über die Berücksichtigung einer Bewerbung, über die Höhe einer Versicherungsprämie oder personalisierte Werbeschaltungen auf Basis von Emotionserkennung.

Zum Umgang mit dem Recht auf Erklärung in der Praxis hat das Research Institute im Auftrag des Bundesministeriums für Arbeit, Soziales, Gesundheit, Pflege und Konsumentenschutz Leitlinien entwickelt:

- Leitfaden für Unternehmen im Umgang mit Art 86 AI Act

- Leitfaden für Konsument:innen und ihre Interessenvertretungen zur Durchsetzung ihrer Rechte

- Theoretischer Grundlagenbericht zur wissenschaftlichen Fundierung der ausgesprochenen Empfehlungen

Meldung von Verstößen und Schutz von Hinweisgebern (Art 87 AI Act)

Zusätzlich normiert Art 87 AI Act, dass für die Meldung von Verstößen und den Schutz von Personen, die solche Verstöße melden, die Richtlinie zum Schutz von Whistleblowern gilt.[79]

Bedeutung von Normen und Standards (Art 40-42 AI Act)

Die Kommission hat die Entwicklung von harmonisierten Normen, die derzeit nicht existieren beauftragt.[80] Solche Normen werden im Amtsblatt der EU veröffentlicht.

Stimmen Hochrisiko-KI-Systeme oder GPAI-Modelle mit solchen harmonisierten Normen überein, wird eine Konformität mit den Anforderungen an Hochrisiko-KI-Systeme (Art 8 ff AI Act) oder gegebenenfalls mit den Pflichten für die Anbieter von GPAI-Modellen (Art 53 ff AI Act) vermutet (Konformitätsvermutung), soweit diese Anforderungen oder Verpflichtungen von den Normen abgedeckt sind (Art 40 AI Act). Diesen harmonisierten Normen kommt somit eine hohe Bedeutung zu, für Rechtssicherheit zu sorgen und die abstrakten Anforderungen des AI Act zu konkretisieren.[81]

| Hinweis: |

|---|

| Derartige harmonisierte Normen befinden sich derzeit in Entwicklung und wurden noch nicht veröffentlicht (siehe unterhalb). |

Subsidiär kann die Kommission, wenn strenge Bedingungen erfüllt sind (harmonisierte Normen wurden nicht ausgearbeitet oder entsprechen nicht dem Auftrag), Durchführungsrechtsakte zur Festlegung gemeinsamer Spezifikationen erlassen, mit denen ebenfalls eine solche Konformitätsvermutung einhergeht (Art 41 AI Act).

Ein Kurzüberblick über die Bedeutung von harmonisierten Normen und in Entwicklung befindliche Normen wurde vom Joint Research Centre der Kommission publiziert.[82]

Weitere Konformitätsvermutungen werden in Art 42 AI Act in Bezug auf die Daten-Governance (Art 10 AI Act) und die Cybersicherheit (Art 15 AI Act) für Hochrisiko-KI-Systeme normiert, die mit entsprechenden Daten trainiert und getestet wurden bzw die Cybersicherheitszertifizierungen durchlaufen sind, normiert.

Das Europäische Komitee für Normung (CEN) und das Europäische Komitee für elektrotechnische Normung (cenelec) wurden mittels Durchführungsbeschluss aufgefordert, bis zum 30. April 2025 bestimmte angeführte Normen auzuarbeiten.[83] Der ursprüngliche Zeitplan konnte nicht eingehalten werden und es erfolgte eine neuerliche Fristverlängerung mittels eines neuerlichen Durchführungsrechtsaktes.[84] Seit November 2025 liegt der erste Entwurf einer harmonisierten Norm zum Qualitätsmanagement "EprEN 18286, Artificial intelligence – Quality management system for EU AI Act regulatory purposes nach Art 17 AI Act zur öffentlichen Kommentierung vor.[85] Die Konsultation zu diesem Normentwurf läuft bis zum 22. Jänner 2026. In den kommenden Monaten sollen weitere Normentwürfe folgen – unter anderem zu Risikomanagement, Cybersicherheit, Vertrauenswürdigkeit und Konformitätsbewertung.

Zudem verabschiedenen CEN/cenelec im Oktober 2025 ein Maßnahmenpaket, um die Fertigstellung wichtiger Normen, die im Rahmen von CEN-CLC/JTC 21 „Künstliche Intelligenz” entwickelt wurden, sowie der im Rahmen des Normungsantrags M/593 (und seiner Änderung M/613) geforderten Ergebnisse zu beschleunigen. Diese Maßnahmen betreffen eine Reihe von Arbeitspunkten, die die technische Grundlage für die künftigen europäischen Normen zur Unterstützung des KI-Gesetzes bilden. Die Vorstände kamen überein, im Falle einer positiven Abstimmung über die Anfrage die direkte Veröffentlichung der Entwürfe ohne separate formelle Abstimmung zuzulassen und CEN-CLC/JTC 21 zu beauftragen, eine kleine Redaktionsgruppe aus bereits aktiven Experten einzurichten, um sechs der am stärksten verzögerten Entwürfe fertigzustellen, bevor sie den jeweiligen Arbeitsgruppen zur Information und für abschließende Kommentare vorgelegt werden.[86]

Als Reaktion auf die verzögerten Standards im Entwurf Digital Omnibus on AI Regulation Proposal[87] bestimmte Maßnahmen vorgeschlagen, um eine zeitnahe, reibungslose und verhältnismäßige Umsetzung bestimmter Bestimmungen des AI-Acts sicherzustellen. Als eine Maßnahme wurde dabei die Kopplung des Zeitplans für die Umsetzung der Vorschriften für hohe Risiken an die Verfügbarkeit von Normen vorgeschlagen.

Synergien

Grundlegende Überschneidungen zwischen dem AI Act und der Datenschutz-Grundverordnung (DSGVO)

- Da KI-Systeme bzw -Modelle häufig personenbezogene Daten verarbeiten - bspw im Rahmen des Trainings eines KI-Modells oder zur Entscheidungsunterstützung in Bezug auf konkrete Personen -, stellt sich unweigerlich die Frage nach dem Zusammenwirken des AI Act mit der DSGVO.[88] Letztere knüpft ihren Anwendungsbereich nämlich an die Verarbeitung personenbezogener Daten iSd Art 4 Abs 1 DSGVO, worunter alle Informationen zu verstehen sind, die sich auf eine identifizierte oder identifizierbare natürliche Person beziehen. Die DSGVO ist seit 2018 in Anwendung und verfolgt den Grundsatz, dass jegliche Verarbeitung personenbezogener Daten verboten ist, es sei denn, es liegt ein Erlaubnistatbestand nach Art 6 Abs 1 DSGVO vor. Für die Verarbeitung sog "sensibler Daten" nach Art 9 DSGVO (zB Gesundheitsdaten, die ethnische Herkunft, die religiöse Weltanschauung etc.) legt sie noch strengere Maßstäbe an. Damit verfolgt die DSGVO einen horizontalen sowie prinzipienbasierten Ansatz, wonach bei der Verarbeitung personenbezogener Daten bestimmte Anforderungen und Grundsätze einzuhalten sind, ungeachtet der verwendeten Technologie, des Sektors oder des Einsatzgebiets.[89] Darüber hinaus orientiert sich die Verordnung daran, inwieweit eine bestimmte Datenverarbeitung ein Risiko für die Rechte und Freiheiten natürlicher Personen darstellt ("risikobasierter Ansatz"), wonach sich letztendlich die Strenge der von ihr vorgeschriebenen Verpflichtungen bemisst.

- Der AI Act erkennt das Primat der DSGVO in Art 2 Abs 7 an und statuiert, dass er deren Anwendungsbereich unberührt lässt. Somit gehen im Falle der Verarbeitung personenbezogener Daten durch eine KI-Anwendung die Regelungen der DSGVO grundsätzlich vor, während der AI Act dem ergänzend eine produktsicherheitsrechtliche Komponente beifügt, die während der Entwicklung und des Einsatzes von KI zu beachten ist.[90]

- Überschneidungen beider Rechtsakte ergeben sich bspw, sobald ein KI-Modell mit personenbezogenen Daten trainiert werden soll. In diesem Fall braucht es eine Rechtsgrundlage nach Art 6 Abs 1 DSGVO (und ggf Art 9 DSGVO), wobei hier am ehesten die berechtigten Interessen des Verantwortlichen nach lit f leg cit infrage kommen. So hat sich bspw der Facebook-Mutterkonzern Meta auf berechtigte Interessen berufen, um sein Sprachmodell "LLaMA" hinter seiner "Meta AI" mit Nutzerdaten zu trainieren. Dagegen erhob die Verbraucherschutzzentrale NRW Antrag auf Erlass einer einstweiligen Verfügung, letztendlich entschied jedoch das OLG Köln in seinem Beschluss vom 23.05.2025 (15 UKl 2/25), dass sich Meta für das KI-Training mit Nutzerdaten auf berechtigte Interessen stützen könne.[91]

Folgenabschätzungen: Datenschutz- und Grundrechte-Folgenabschätzung

- Der Anwendungsbereich einer Datenschutz-Folgenabschätzung (Art 35 DSGVO) kann sich mit einer Grundrechte-Folgenabschätzung (Art 27 AI Act) überschneiden, wobei eine integrierte Folgenabschätzung durchgeführt werden kann.[92]

- Umgekehrt ist laut Art 35 DSGVO immer dann eine Datenschutz-Folgenabschätzung durchzuführen, wenn eine Datenverarbeitung voraussichtlich ein hohes Risiko für die Rechte und Freiheiten natürlicher Personen zur Folge hat, insbesondere bei Verwendung neuer Technologien. Darunter fallen gemäß §2 Abs 2 Z 4 DSFA-V[93] insbesondere Datenverarbeitung unter Einsatz von künstlicher Intelligenz, welcher jedenfalls die Verpflichtung zur Durchführung einer Datenschutz-Folgenabschätzung nach sich zieht. Somit löst auch der Einsatz von KI unter gewissen Voraussetzungen datenschutzrechtliche Pflichten aus.

Verarbeitung von sensiblen Kategorien personenbezogener Daten (Art 9 DSGVO)

- Um Verzerrungen (Bias) zu zu erkennen und zu korrigieren, dürfen Anbieter, wenn es unbedingt erforderlich ist, unter strengen Auflagen sensible Kategorien von personenbezogenen Daten (Art 9 DSGVO) verarbeiten (Art 10 Abs 5 AI Act).[94]

- Bei der Entwicklung/Training leistungsfähigerer KI-Modelle kann es zu Friktionen zwischen Art 15 AI Act, der angemessene Genauigkeit iSv Performanz fordert, und Art 9 DSGVO, der die Verarbeitung sensibler personenbezogener Daten prinzipiell verbietet, kommen.[95] Zwar gab der Europäische Datenschutzausschuss Ende 2024 eine Stellungnahme zum Training von KI-Modellen heraus, diese behandelt die potentielle Friktion mit Art 9 DSGVO jedoch nur am Rande.[96]

Unterschiedliche Verantwortlichkeiten

- Die DSGVO stellt primär auf den Verantwortlichen ab. Diese Rolle wird häufig der Betreiber iSd AI Act einnehmen. Die meisten Pflichten nach dem AI Act sind aber primär an Anbieter adressiert. Daher kann es zu einem Auseinanderfallen der Verantwortlichkeiten kommen.[97]

Risikoanalyse: Digital Services Act (DSA) vs AI Act

- Der DSA legt einheitliche Regeln für Vermittlungsdienste mit dem Ziel fest, ein vertrauenswürdiges, (rechts-)sicheres und vorhersehbares Online-Umfeld für Verbraucher und Unternehmen durch eine harmonisierte Plattformregulierung zu gewährleisten. Ebenso zielt das Regelwerk auf den Schutz sowie die Gewährleistung einer effektiven Grundrechtsausübung und normiert umfassende Verpflichtungen für Anbieter von Online-Diensten in Form eines abgestuften Regelungsansatzes, der die unterschiedlichen Compliance-Pflichten an die Art und Größe der jeweiligen Online-Dienste knüpft. Dabei kennt der DSA folgende Anbieterkategorien: Anbieter von allgemeinen Vermittlungsdiensten, Hostingdiensten, Online- sowie Transaktionsplattformen und sehr großen Online-Plattformen (VLOPs) und -Suchmaschinen (VLOSEs). Überschneidungen mit dem AI Act können sich auf zweierlei Weise ergeben: Einerseits können KI-Anwendungen zur Generierung oder Manipulation von Inhalten verwendet werden, die dann über Vermittlungsdienste geteilt werden. Andererseits können KI-Systeme das Kernangebot des Diensteanbieters ausmachen, in der Inhaltsmoderation eingesetzt werden oder Produkt- bzw Service-Empfehlungen auf Basis von Nutzerverhalten ("Empfehlungsalgorithmen") schalten.[98] Allgemeine Synergien sind dem Eintrag über den DSA zu entnehmen.

- Weiters kann es bei VLOPs und VLOSEs, die generative KI, bspw GPAI-Modelle, integrieren, zu einer Überschneidung zwischen DSA und AI Act in Bezug auf die notwendige Risikoanalyse kommen. So fordern die Artikel 34 und 35 DSA die Analyse jener potenzieller systemischer Risiken, die sich durch das Design, die Funktion oder die Nutzung ihrer Services ergeben, insbesondere im Zusammenhang mit algorithmischen Systemen oder Systemen zur Inhaltsmoderation. Demgegenüber legt der AI Act in Art 17 die Verpflichtung für Anbieter von Hochrisiko-KI-Systemen zur Etablierung eines Risikomanagementsystems gemäß Art 9 AI Act fest und sieht spezielle Anforderungen für Anbieter von GPAI-Modellen mit systemischem Risiko vor (Art 55 Abs 1 lit b AI Act). Daher wird teilweise für eine konsolidierte und technologieübergreifende Risikoanalyse plädiert, wobei dem Umstand, dass mehrere Technologien verknüpft sind, entsprechend Rechnung getragen werden muss.[99] Im Fall von Anbietern von Hochrisiko-KI-Systemen sieht der AI Act sogar explizit die Möglichkeit vor, Risikomanagementprozesse nach anderen unionsrechtlichen Bestimmungen mit jenen nach dem AI Act zu kombinieren (vgl Art 9 Abs 10 AI Act).[100]

Überlappende Anforderungen mit anderem Produktsicherheitsrecht

- Art 8 Abs 2 AI Act betont für Produkte, die bereits untere andere Produktsicherheitsvorschriften fallen (Anhang I Abschnitt A), "im Hinblick auf die Gewährleistung der Kohärenz, der Vermeidung von Doppelarbeit und der Minimierung zusätzlicher Belastungen" die Anbieter die Wahl haben, die erforderlichen Test- und Berichterstattungsverfahren, Informationen und Dokumentationen gegebenenfalls in existierende Dokumentationen und Verfahren zu integrieren.

Integriertes/kombiniertes Risikomangement

- Anbieter von Hochrisiko-KI-Systemen, die den Anforderungen an interne Risikomanagementprozesse gemäß anderen einschlägigen Bestimmungen des Unionsrechts unterliegen, können die in Art 9 AI Act enthaltenen Aspekte als Bestandteil der nach diesem Recht festgelegten Risikomanagementverfahren integrieren bzw die Verfahren kombinieren (Art 9 Abs 10 AI Act).

Cybersicherheitsanforderungen

- Art 15 Abs 1 AI Act normiert, dass Hochrisiko-KI-Systeme so konzipiert und entwickelt werden müssen, dass sie ein angemessenes Maß an Genauigkeit, Robustheit und Cybersicherheit erreichen. Neben den in Art 15 Abs 5 AI Act konkretisierten speziellen Maßnahmen an die Cybersicherheit von KI-Systemen bleiben auch andere Anforderungen, bspw nach NIS2-RL anwendbar.

Recht auf Erläuterung